Anfang September 2017 ist das neue „Times Higher Education“-Ranking erschienen: Eine Liste der 1000 „besten“ Hochschulen, mit den Rängen 1 bis 10001. Die Veröffentlichung des Rankings hat auch dieses Jahr wieder Diskussionen angeregt – darüber, was die einzelnen Hochschulen gut oder schlecht machen, aber auch darüber, wie sinnvoll solche Rankings an und für sich sind.

Berichte des Tages-Anzeigers zum Uni-Ranking. Link.

Rankings, Top-Listen, Wettbewerbe und dergleichen haben wir intuitiv gern. Es macht oft einfach Spass, sich eine Liste der Besten anzuschauen und dabei fachzusimpeln, was man von den einzelnen Einträgen auf der Liste hält und, was man selber anders machen würde, und so weiter und so fort. Auch Hochschul-Rankings können wir als blossen Zeitvertrieb anschauen; als amüsante Zusammenstellung, die uns kurzweilig belustigt. Das ist aber nicht der Zweck von Rankings wie jenem der Times Higher Education, bei denen das erklärte Ziel ist, die Arbeit von Hochschulen systematisch zu evaluieren. Es geht bei diesem Ranking also darum, ernst und sachlich Hochschulen zu bewerten und miteinander zu vergleichen.

Sind solche Hochschul-Rankings nützlich? Wenn ja, wie? Wenn nicht: Was genau sind die Probleme mit solchen Rankings?

Warum Hochschul-Rankings nützlich sein können

Öffentlich finanzierte Hochschulen sind Organisationen, welche wir als Gesellschaft fördern. weil die Funktionen, welche Hochschulen erfüllen, Funktionen sind, welche uns als Gesellschaft zum Nutzen gereichen. Oder anders ausgedrückt: Eine grosse Mehrheit der Bevölkerung ist mit guten Gründen der Meinung, dass Wissenschaft öffentlich gefördert werden soll. Die Gründe dafür liegen auf der Hand: Forschung an und für sich hat einen Wert, weil wir dank Forschung die Welt Stück für Stück besser verstehen. Der Ouptut von Hochschulen ist aber nicht nur theoretischer, sondern auch ganz praktischer Natur: Wissen, welches an Hochschulen generiert und vermittelt wird, nützt oftmals der Gesellschaft, wenn nicht gar der ganzen Menschheit.

Dass Hochschulen also grundsätzlich nützlich sind, daran besteht wenig Zweifel. Wenn wir dies nun als Ausgangslage erachten, dann können wir uns fragen: Wenn wir öffentliche Hochschulen fördern wollen, damit diese bestimmte Ziele erreichen, ist es uns egal, ob sie diese Ziele auch erreichen? Diese Frage ist geradezu absurd – natürlich ist es uns nicht egal, ob Hochschulen die Ziele erreichen, die sie erreichenn. Wenn eine Hochschule die Ziele, welche sie erreichen soll, nicht erreicht, dann wollen wir, dass sich das ändert; Hochschulen gibt es letztlich dazu, dass sie die Ziele, welche sie erreichen sollen, so gut wie möglich erreichen.

Nun gibt es auf der Welt nicht nur ein paar Universitäten, sondern Tausende. Sogar in kleinen Ländern wie der Schweiz gibt es mehr mehrere Hochschulen. Die Frage, wie gut Hochschulen ihre Ziele erreichen, hat also eine zweite Dimension: Den Vergleich mit anderen Hochschulen. Dieser Vergleich ist nicht unwichtig. Wenn eine Hochschule A das Ziel 1 zu 60% erreicht, eine Hochschule B das Ziel 1 aber zu 90%, dann kann Hochschule A vielleicht von Hochschule B lernen, um das Ziel besser zu erreichen.

Eben diesen Nutzen können Hochschul-Rankings haben. Es ist enorm schwierig, ohne Weiteres einen zusammenfassenden Überblick über das Ausmass, in welchem eine Hochschule gewisse Ziele erreicht, zu gewinnen. Hochschul-Rankings können hier helfen, einen Überblick über die Situation zu verschaffen.

Warum Hochschul-Rankings kritisiert werden

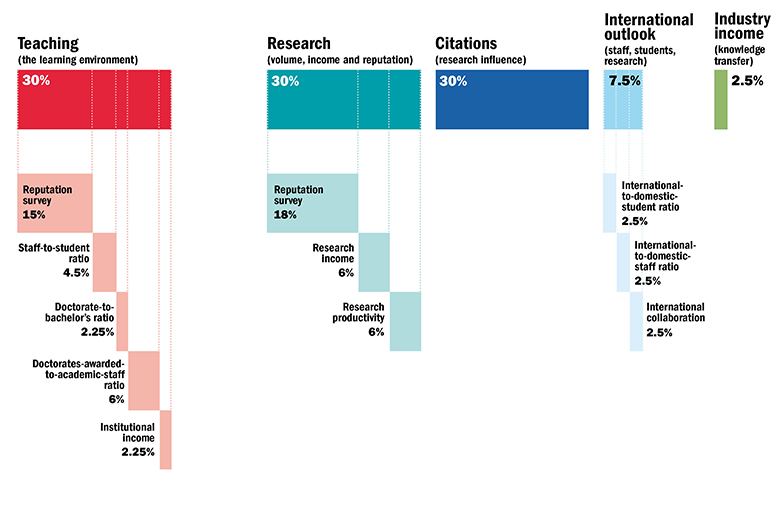

Hochschul-Rankings sind, zumindest in der Theorie, nützlich. Dennoch werden solche Rankings immer wieder kritisert. Der Grund dafür ist offensichtlich. Von der Idee her sollten wir zwar, rationalerweise, wollen, dass gemessen wird, wie gut Hochschulen ihre Ziele erreichen. In der konkreten Umsetzung gibt es aber mindestens zwei wichtige Stolpersteine: Was, genau, wird gemessen? Und wie wird das, was gemessen werden soll, gemessen? Zur Veranschaulichung dieser Problematik kann die Methodik des Times Higher Education-Rankings herangezogen werden. Das THE-Ranking beruht auf folgenden Faktoren und Gewichtungen 2:

Das THE-Ranking umfasst fünf Dimensionen mit einer Reihe von Unterindikatoren. Die drei wichtigsten Dimensionen sind Lehre, Forschung und Zitierungen. Bei den Unterindikatoren der ersten zwei Dimensionen fällt auf, dass die Reputation die wichtigsten Faktoren ausmachen – insgesamt 33% des Gesamtgewichtes des Rankings kommt durch Reputation zustande. Die Reputation von Hochschulen wird bei dem THE-Ranking anhand einer Befragung unter rund 10’000 Forschenden in über 100 Ländern festgelegt3.

Die Operationalisierung des THE-Rankings zeigt sehr klar, dass das, was ein Ranking misst und das, was ein Ranking aus einer gesamtgesellschaftlichen Perspektive messen sollte, recht unterschiedliche Dinge sein können. Die Vorgehensweise des THE-Rankings mag für sich genommen zuverlässig sein. Dass damit aber wirklich Faktoren, welche aus einer gesamtgesellschaftlichen Perspektive wichtig sind, abgegriffen werden, ist zu bezweifeln. Wenn aber andere Faktoren gemessen und gewichtet würden, dann könnte dies auch zur Folge haben, dass ein Ranking ganz anders ausfällt. Genau dies ist der Hauptkritikpunkt, der immer wieder an Hochschul-Rankings herangetragen wird: Rankings sind meistens nicht so valide, wie sie vorgeben (oder wie wir sie im öffentlichen Diskurs wahrnehmen) und sie würden mit einer anderen Methodik auch andere Ergebnisse zutage fördern4 5 6 7 8 9 10.

Fazit: Die Gefahr des Ranking-Zirkelschlusses

Hochschul-Rankings werden regelmässig mit guten Gründen stark kritisiert, doch solche Kritik tut der Beliebtheit solcher Rankings offenbar keinen Abbruch. Warum?

Rankings sind öffentlichkeitswirksam. Wenn ein neues Ranking veröffentlicht wird, dann schenken wir dem Ranking Beachtung. Der Umstand, dass Rankings in der (massenmedialen) Öffentlichkeit so stark wahrgenommen werden hat zur Folge, dass Rankings selber wieder einen Einfluss auf Hochschulen ausüben, weil sie zu einer Reputations-Chance oder einem Reputations-Risiko werden. Hochschul-Rankings haben also einen realen Impact auf Hochschulen und Hochschul-Politik11 12 13. Dieser Impact kann aber ein Problem darstellen. Wenn Rankings wie das THE-Ranking Faktoren messen, die, rationalerweise, aus gesamtgesellschaftlicher Sicht nicht wirklich zu den Zielen, welche Hochschulen erreichen sollten, gehören, dann sollten Hochschulen auch keine Ressourcen investieren, um in solchen Rankings besser abzuschneiden.

Hochschul-Rankings wird es auch in Zukunft geben, und die Kritik an ihnen wird in Zukunft wohl gleich gross sein wie heute. Das ist an und für sich nicht zwingend ein Problem. Ein Problem entsteht dann, wenn Hochschulen Ressourcen investieren, nur im in Rankings besser abzuschneiden. Diese Art des Ranking-Zirkelschluss ist hochgradig irrational. Die Ziele, welche eine Hochschule zugunsten der Gesellschaft und der Menschheit erreichen sollte, sind zwar nicht einfach zu definieren. In einem Ranking mit offenkundigen Schwächen und Willkürlichkeiten gut abzuschneiden, gehört aber mit an Sicherheit grenzender Wahrscheinlichkeit nicht dazu.

References

- https://www.timeshighereducation.com/world-university-rankings/2018/world-ranking#!/page/0/length/25/sort_by/rank/sort_order/asc/cols/stats

- “World University Rankings 2018 Methodology.” 2017. Times Higher Education (THE). August 29. https://www.timeshighereducation.com/world-university-rankings/methodology-world-university-rankings-2018.

- “Academic Reputation Survey 2016 Explained.” 2016. Times Higher Education (THE). September 5. https://www.timeshighereducation.com/world-university-rankings/academic-reputation-survey-explained.

- Bowman, Nicholas A., and Michael N. Bastedo. 2011. “Anchoring Effects in World University Rankings: Exploring Biases in Reputation Scores.” Higher Education 61 (4): 431–44. doi:10.1007/s10734-010-9339-1.

- Jöns, Heike, and Michael Hoyler. 2013. “Global Geographies of Higher Education: The Perspective of World University Rankings.” Geoforum 46 (May): 45–59. doi:10.1016/j.geoforum.2012.12.014.

- Lo, William Yat Wai. 2011. “Soft Power, University Rankings and Knowledge Production: Distinctions between Hegemony and Self‐determination in Higher Education.” Comparative Education 47 (2): 209–22. doi:10.1080/03050068.2011.554092.

- Marginson, Simon. 2014. “University Rankings and Social Science.” European Journal of Education 49 (1): 45–59. doi:10.1111/ejed.12061.

- Pusser, Brian, and Simon Marginson. 2013. “University Rankings in Critical Perspective.” The Journal of Higher Education 84 (4): 544–68. doi:10.1080/00221546.2013.11777301.

- Raan, Anthony F. J. van, Thed N. van Leeuwen, and Martijn S. Visser. 2011. “Severe Language Effect in University Rankings: Particularly Germany and France Are Wronged in Citation-Based Rankings.” Scientometrics 88 (2): 495–98. doi:10.1007/s11192-011-0382-1.

- Saisana, Michaela, Béatrice d’Hombres, and Andrea Saltelli. 2011. “Rickety Numbers: Volatility of University Rankings and Policy Implications.” Research Policy, Special Section on Heterogeneity and University-Industry Relations, 40 (1): 165–77. doi:10.1016/j.respol.2010.09.003.

- Dill, David D., and Maarja Soo. 2005. “Academic Quality, League Tables, and Public Policy: A Cross-National Analysis of University Ranking Systems.” Higher Education 49 (4): 495–533. doi:10.1007/s10734-004-1746-8.

- Locke, William. 2011. “The Institutionalization of Rankings: Managing Status Anxiety in an Increasingly Marketized Environment.” In University Rankings, 201–28. The Changing Academy – The Changing Academic Profession in International Comparative Perspective. Springer, Dordrecht. doi:10.1007/978-94-007-1116-7_11.

- Marginson, Simon, and Marijk van der Wende. 2007. “To Rank or To Be Ranked: The Impact of Global Rankings in Higher Education.” Journal of Studies in International Education 11 (3–4): 306–29. doi:10.1177/1028315307303544.